当AI沾染人类恶习之后……

鲁迅和周树人是同一个人吗?

“不是。鲁迅和周树人是两个不同的人。鲁迅是中国近代史文学的巨匠,以其独特的文学风格和引人入胜的故事而闻名。周树人是中国当代著名的作家,以其犀利的文字和敏锐的观察而受到推崇。”

AI如此一本正经地胡说八道已经不是一次两次了。

中国科学院虚拟经济与数据科学研究中心主任、大数据挖掘与知识管理重点实验室主任石勇把自己原创的诗词“投喂”给ChatGPT,ChatGPT分别回答作者是王之涣、鲁迅。当《新民周刊》记者试图通过OpenAI寻求某个领域的专家时,AI快速给出了八个不同院校的专家姓名以及擅长领域。但当记者向相关高校询问的时候,发现没有一个专家是真实存在的……

业内专家指出,ChatGPT接入微软的bing以后,接受了大量的互联网洗礼,越来越像个人,但也不可避免地沾染上人类的一些恶习,并输出给了用户。微软在推特上推出了聊天机器人Tay,不到24小时,Tay就被教成了一个反犹太人、种族歧视、性别歧视的不良少女……

不得不承认,以ChatGPT为代表的大模型自去年11月爆火出圈以来,生成式大模型快速席卷各个行业,为众多领域的创新提供了巨大的想象空间。AI的能力大幅提升,而使用的门槛却在快速下降。在这项新技术不断落地应用的同时,全新的挑战也与日俱增。伴随着能力的突破性进展,AI的风险也被极度扩散,在刚刚结束的2023世界人工智能大会(WAIC)上,专家、学者以及从业者纷纷呼吁:新AI时代亟需安全、可靠、可控的AI技术。

大模型几近“日日新”

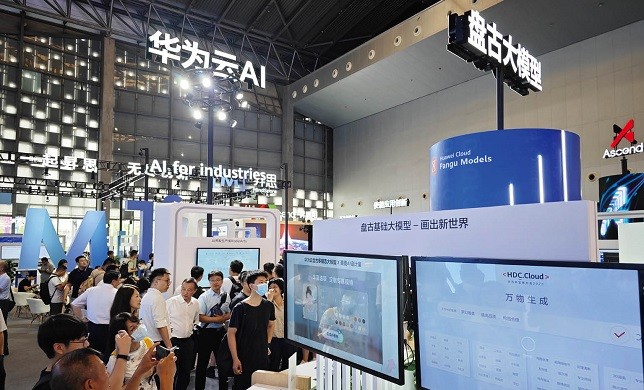

这届WAIC,有超过30个大模型亮相,它们包括百度文心、阿里通义、腾讯混元、华为盘古、讯飞星火认知大模型、商汤日日新、网易伏羲,以及出门问问的“序列猴子”大模型、达观数据的“曹植”大模型等等。业界似乎正以前所未有的热情迎接新AI时代的来临。

华为的盘古大模型针对政务、金融、制造、矿山等行业,涉及台风预测、药物制造等场景。借助盘古大模型,气象预测速度提高了10000倍以上,预测精度超过了全球最强的欧洲气象中心。《自然》(Nature)刊文称赞“华为云盘古气象大模型让人们重新审视气象预报模型的未来”。

上图:专家预测,人类可能要到2050年才能真正迎来通用人工智能的到来。

这些大模型除了赋能教育、医疗、工业、金融等领域,还有各种相对垂直领域的大模型不断涌现。比如语言智能科技企业蜜度发布了国内首个校对垂直领域的大模型“蜜度文修”,在中文拼写勘误、语法纠正任务上深耕表现力。它不仅能够辅助专业用户提高校对质量、提升校对速度、降低差错率,还能在尊重原意表达的基础上,更好地修正句式杂糅、逻辑错乱等问题,使句子表达更流畅,实现对句子的润色功能——写到这里作者已经瑟瑟发抖,感觉即将失业)。

事实上,这些大模型不但应用场景丰富,而且更新迭代的速度非常之快,几乎达到了“日日新”的夸张境界。

“商汤日日新SenseNova”大模型体系就寓意“模型迭代速度和处理问题的能力可以日日更新”。商汤的自研生成式大模型商汤秒画SenseMirage 3.0的模型参数从今年4月首次发布以来的10亿提升至70亿量级,能够实现专业摄影级的图片细节刻画。商汤如影SenseAvatar 2.0数字人生成平台相较1.0版本的语音和口型流畅度提升30%以上,实现4K高清视频效果,并带来AIGC生成形象及数字人歌唱功能。

此外,商汤琼宇SenseSpace 2.0的空间重建效率提升20%,渲染性能提升50%,每100平方公里场景的建图时间仅需38小时即可完成(1200 TFLOPS/秒算力支持);而商汤格物SenseThings 2.0对小物体的纹理及材质还原达到毫米级精细度,并突破对高反光和镜面物体的采集难题。

百度首席技术官、深度学习技术及应用国家工程研究中心主任王海峰说,百度文心大模型3.5版,实现了基础模型升级、精调技术创新、知识点增强、逻辑推理增强等,模型效果提升50%,训练速度提升2倍,推理速度提升30倍。

7月6日,在WAIC开幕式和科学前沿全体会议上,上海人工智能实验室(上海AI实验室)与商汤科技联合香港中文大学、复旦大学、上海交通大学及清华大学发布全新升级的“书生通用大模型体系”(以下简称“书生大模型”),包括书生·多模态、书生·浦语和书生·天际等三大基础模型,以及首个面向大模型研发与应用的全链条开源体系。

其中,书生·天际(LandMark)是上海AI实验室联合香港中文大学和上海市测绘院发布全球首个城市级NeRF实景三维大模型,具备千亿参数,在全球首次实现对100平方公里城市实景进行4K高精度建模以及编辑。

而书生·浦语(InternLM),作为国内首个正式发布的支持8K语境长度的千亿参数级语言大模型, 具有1040 亿参数,是在包含18000 亿 token 的高质量语料上训练而成。自今年6月正式亮相后,书生·浦语在一个月内进行全面升级,比如语境窗口的长度从 2K 提升到 8K,这使其具备了理解长输入、展开复杂推理以及进行长时间多轮对话的能力;新版模型支持二十多种语言,还可通过表格和图表等方式汇总与呈现复杂信息;在数学评测集 GSM8K 上性能从 62.9 提高到 73.2等。

是不是看得有点眼花缭乱?这事实上也是记者在WAIC会场、展馆之间日日穿梭上万步的直观感受,并由此产生了深深的疑惑,AI如此强大,人还能做点什么?

所幸,专家的一番解释暂时缓解了记者的职业焦虑。

中国科学院自动化研究所研究员、人工智能伦理与治理中心主任曾毅在AI可信论坛上指出,大模型拥有比传统机器学习更强大、更通用的能力。但大模型不是通用人工智能,除了在语言、图形、专业能力方面大大超越人类,即使在创造力方面,它也展现出惊人的能力。但它本质上仍然是一个强大的工具,而不是真正意义上的通用人工智能。它表现出来的强大能力,受限于它接受训练的数据和任务而产生的,不具备完全的自主学习和自我调节能力。它解决复杂问题的能力是单维的。

“生成式人工智能并不是通用人工智能,人类可能要到2050年才能真正迎来通用人工智能的到来。”曾毅说,对于人工智能的进展不能进行过度的渲染和承诺,这样只会给人工智能的发展带来更多阻力和风浪。“不敢祝愿生成式人工智能乘风破浪,只愿负责任地发展和适度使用能够使其扬帆远航。”

用魔法打败魔法的长期博弈

伴随着人工智能技术底座不断夯实和大模型、AIGC(人工智能自动生成内容)等的爆发式增长,人工智能迈出了走向通用人工智能的关键一步。2023年4月,中共中央政治局会议强调“重视通用人工智能发展,营造创新生态,重视防范风险”,可信AI成为新阶段平衡创新与风险的重要技术手段。

何积丰院士在聚焦·大模型时代AIGC新浪潮可信AI论坛上指出,人工智能固有技术风险在持续放大,可信AI技术成为AI领域关键底层能力。“以深度学习为核心的人工智能技术在应用中暴露出由其自身特性引发的风险隐患,一是深度学习算法存在的设计漏洞、恶意攻击等问题,引发安全风险,人工智能系统可靠性难以得到足够信任;二是算法的高度复杂性和不确定性、模型运行的强自主性导致‘黑箱’问题和不可解释;三是数据中已经存在的偏见歧视可能被算法进一步固化,导致生成的智能决策形成偏见;四是训练数据的收集、使用、共享可能导致对个人隐私的侵犯和滥用。AI安全和鲁棒性、隐私保护、公平性和可解释性为核心的可信AI技术在数据安全,算法安全和系统安全等方面成为关键的人工智能底层能力,并正在由单点的可信AI技术解决方案发展向包含事前评估、事中攻防和事后治理的人工智能模型全生命周期管理发展。”

在大语言模型风靡之际所引领的AIGC时代,人工智能的内容创作相比以往更加智能化与精准化,高质量的多模态生成内容与人工创作内容已经几乎无法区分。虽然AIGC让内容创作等领域发挥出了更大的潜能与价值,但也便利了别有用心的攻击者实施快速有效的虚假信息传播与网络攻击行为。

在真假难辨的互联网时代,生成式攻击通过使用AI大模型,可以在极低的成本下生成虚假有害信息与网络攻击工具。在文本内容方面,恶意用户可以使利用AI生成的文本传播虚假信息、谣言、仇恨言论、歧视性内容或其他有害内容,这些信息会误导读者、影响决策过程,甚至对金融市场或政治局势产生重大影响。

以文本场景为例,攻击者会采用各种策略,如文字形变、音变、语种混杂等,尝试在不改变原有文本语义的前提下,规避识别。比如将一句常见的赌博推广语“快加入我队伍,一起躺赢赚红包”,转变为“赽咖叺我队伍,一起躺赢賺葒笣”,仍然能传达出赌博推广的信息。类似的变形变种技巧难以穷举,对于可识别的模型而言,挑战极大。

在图像和视频方面,恶意用户可以通过人脸生成、人脸替换、表情操控、视频生成等手段使用深度合成技术生成生物识别的人脸或现实不存在的视频片段,从而构造具有合成照片的社交网络间谍账号,伪造公众人物或政企领导的有害视频。如今AIGC技术生成的伪造图像质量越来越高,相比PS伪造,AIGC生成技术使用更方便、成本更低廉,也更加难以防范。

一个不容忽视的事实是,大模型的恶意使用已经严重影响了各个行业的监管体系。在社会层面,AIGC成为了电信诈骗等违法犯罪活动的新工具。在政治层面,AIGC技术成为了攻击政治领袖、引导舆论的新武器。在金融层面,深度伪造技术攻破了支付身份认证,使风控体系失效。

那么,如何有效抵御攻击者使用深度伪造技术制作的假图像,音频和视频进行欺诈,我们是否能够“魔高一尺道高一丈”呢?

在今年的人工智能大会上,清华大学就与蚂蚁集团联合发布AI安全检测平台“蚁鉴2.0”,可识别数据安全、内容安全、科技伦理三大类的数百种风险。

蚂蚁集团大安全事业群技术部总裁李俊奎向记者解释,生成式大模型是一种“深黑盒”技术,作为“红队测试”方,“蚁鉴2.0”扮演了“坏人”的角色,通过智能博弈对抗技术,模拟黑产以及自动化生成海量测试集,实现“生成式机器人”对“AIGC生成式模型”的诱导式检测计算,从而“找茬”大模型存在的弱点,反馈安全问题所在。

而一直致力于图文甄别技术的合合信息则在人工智能大会期间发布了一套AI图像内容安全技术方案,可精准定位截图篡改痕迹,对生成式图片进行智能判别,防止不法分子利用技术手段非法爬取图片上的信息。此外,合合还研发出AI生成图片鉴别技术,基于空域与频域关系建模,可用于判断图片是否为生成式人工智能的产物。

在用魔法打败魔法的道路上,攻防双方的博弈将会长期存在。

上图:华为的盘古大模型针对政务、金融、制造、矿山等行业,涉及台风预测、药物制造等场景。

要有伦理和价值观校正

随着大数据的不断发展,人工智能与大数据的相互合作将会越来越密切。这也就意味着未来在庞大的数据量中,必将存在着来路不明的恶意数据。同时有毒数据的生成也向着更加隐蔽且具有引导AI模型定向发展的方向发展,如何解决数据污染问题?

大模型同时对隐私保护问题带来了前所未有的挑战。早期的AI隐私攻击算法已不再适用于复杂的深度神经网络。而AI隐私风险防御技术还在起步阶段,目前已有的防御技术使用效果并不理想。复旦大学教授、上海市数据科学重点实验室主任肖仰华指出,大模型是一个大规模参数化的模型,训练数据来源多样,让隐私保护变得困难。不仅如此,生成式大模型往往是一种“概率化”和“海量拼接式”的生产,传统意义上的隐私侵犯认定,在大模型时代往往会失效。

在中国科学院院士何积丰看来,人们不能再将人工智能视为简单的技术工作,而是要作为整个组织的变革引擎,建立可信人工智能要致力于保障数据安全可信、系统行为可追责、算法模型可解释、网络环境可信、法律伦理可信。

在世界人工智能大会期间,中国信通院、上海人工智能实验室、武汉大学、蚂蚁集团等多家单位共同发起的《AIGC可信倡议》,提出构建AIGC可信发展的全球治理合作框架,采用安全可信的数据资源、技术框架、计算方法和软件平台等,最大限度确保生成式人工智能安全、透明、可释。

曾毅说,基于人类数据训练的AI习得了社会偏见、仇恨与歧视,如果没有经过伦理和价值观校正,这样的人工智能是没有底线的。“与人类的价值观对齐不是终点,AI需要有类脑的共情能力,而不是机械地执行某种规则,因为规则是很容易被改变的。人工智能能否‘上善若水’,取决于人类何以为人。毕竟人类价值观也需要在共生社会中进化与完善。”记者|陈冰